WAIT_TIME=10

#define apl_keycode_space 32

GPB_converter_title = "GPB converter ver"

goto *main

#deffunc select_text_all

keybd_event 17,0,0,0 ; VK_CONTROLキーを押す

keybd_event 'A',0,0,0; aキーを押す

keybd_event 'A',0,2,0; a:KEYEVENTF_KEYUP キーをはなす

keybd_event 17,0,2,0 ; VK_CONTROL:KEYEVENTF_KEYUP キーをはなす

;aplkey 46: wait 10

wait 10

return

*mainarm64 ubuntu linuxのgasでpc98で起動する画像プログラムを書いて、画像プログラム起動システムを書きこんだフロッピーディスクの仮想イメージをつくった

エミュを使ってIPLプログラミングもどき (2)(PC-98のプログラム作成に関するエトセトラ)を参考に、gasとnp2kaiでやってみた。

asm1.S

.code16

.text

.globl _start

.org 0

_start:

mov $0x0a000, %ax

mov %ax, %es

mov $23, %cx

mov $0x2000, %di

add $80, %di

mov $0x0f1, %ax

POINT1:

push %cx

mov $30, %cx

rep stosw

pop %cx

add $100, %di

loop POINT1

mov $23, %cx

mov $0x087, %ax

mov $80, %di

POINT2:

push %cx

mov $30, %cx

rep stosw

pop %cx

add $100, %di

loop POINT2

POINT3:

jmp POINT3

.org +0x400asでアセンブルして、How to generate plain binaries like nasm -f bin with the GNU GAS assembler?(stackoverflow)を参考にldとobjdumpでバイナリコードだけにし、初心者のためのPC-98プログラミング(1)【OS無しでbeepを鳴らす】(qiita)を参考にhoodと結合して、np2で起動する.TFDフロッピーイメージファイルにする。

“arm64 ubuntu linuxのgasでpc98で起動する画像プログラムを書いて、画像プログラム起動システムを書きこんだフロッピーディスクの仮想イメージをつくった” の続きを読むMS-IMEにテキスト辞書を登録

ユーザーコメント付きの辞書を登録したくてやってみた。

MS-IMEにインポートできるMicrosoft IME 形式テキスト(*.txt)は、

- メモ帳で作れるプレーンテキスト

- 文字コードはUTF-16 LE

- 「!」文字の後ろはコメントに見なされて書いてない扱いになる。

- 登録する単語は1語を、よみ・単語・品詞・ユーザーコメントの順にそれぞれをタブ文字で区切った1行で書く。※品詞の種類の一覧はMS-IMEのプロパティを参照。

- ユーザーコメントは120文字数ぐらいの制限があるらしい。ユーザーコメントは変換候補をスペースキーで出したときに、その登録単語で待つとポップアップで見れる。

!よみ 単語 品詞 ユーザーコメント

あおじろ 青白 名詞 白みがかった青いいろのこと。"pale" #小学1年生

しけん 試験 名詞 何かをしらべること。"test","examin" #小学4年生スイート千鳥エンジン

デバッガに使われるリソースを置くフォルダはVCXPROJファイルがあるフォルダ(プロジェクトフォルダ)です。

ex. C:\SuiteChidoriEngine\tutorial\Windows\Tutorial

[macOS]neko project IIでpc98アセンブラ

neko projectIIを入れる

※マック用のSDL2.framework を /Library/Frameworks にコピー(ReadMe.txtより)

Garbage for FreeDOSからFreeDOS(98)起動ディスクイメージをダウンロードして解凍

上記ディスクは250MBですが、拙作1.2MBディスクにFreeDOS、SE3、LHAを入れたデモ作成用フロッピーディスクイメージ (.d88形式)を置いておきます。

“[macOS]neko project IIでpc98アセンブラ” の続きを読む音声認識エンジン Julius ブラウザ版

emscriptenのツールエラーメモ (emscripten’s error tips)

Error: Cannot find module ‘acorn’

emscriptenのバージョンを変えた(リポジトリのタグでチェックアウトした)時に起きた

cd $EMSCRIPTEN

npm install

emcc: error: wasm2js does not support source maps yet (debug in wasm for now)

このエラーはたぶんWASM=0 -g4にしてると出るはず。

-g3: When compiling to object files, keep debug info, including JS whitespace, function names, and LLVM debug info if any (this is the same as -g).

-g4: When linking, generate a source map using LLVM debug information (which must be present in object files, i.e., they should have been compiled with -g).

emscripten_sleep()

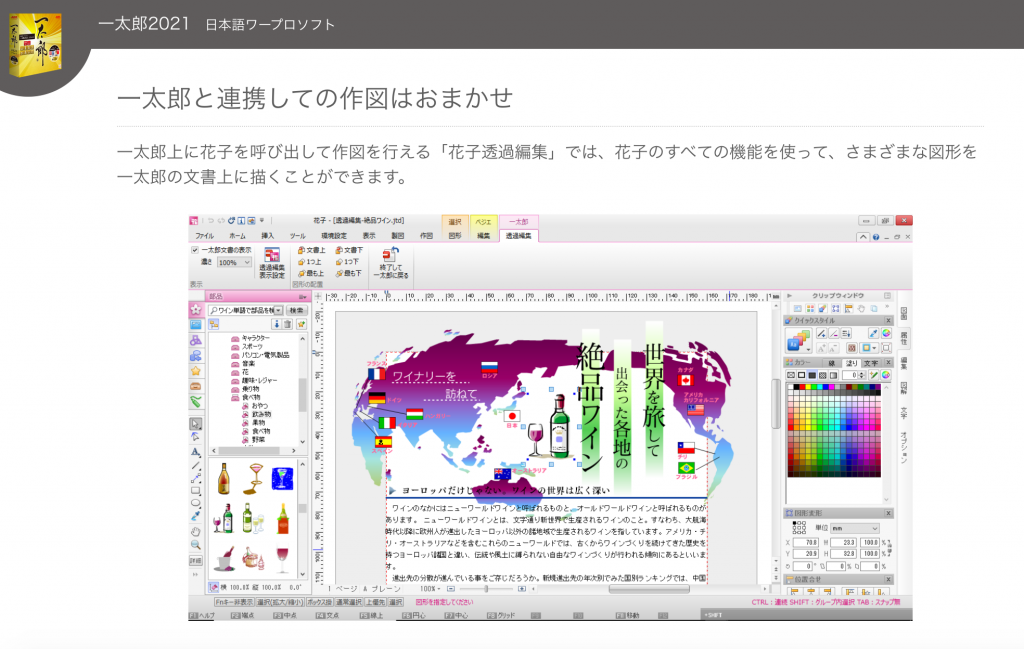

emcc -s EMTERPRETIFY=1 -s EMTERPRETIFY_ASYNC=1 # 〜v1.39.16, EMTERPRETIFY* is supported by the LLVM wasm backendemcc -s ASYNCIFY=1 # v1.39.17〜 【JUSTSYSTEM】一太郎と花子のスカイラブハリケーン

なんか強そうだと思った。

プログラミング言語とツールとグラフィックライブラリ

| C++ | SDL1.2 |

| Emscripten | ?? |

| Qt(mingw) | 未 |

| NetBeans(cygwin) | 未 |

| VC(vc++2019 cl.exe) ※SDL1.2のライブラリファイルをソース(SDL-1.2.15.zip)からビルド | ?? |

| VC(vc++2019 clang)※SDL1.2のライブラリファイルをソース(SDL-1.2.15.zip)からビルド | ?? |

| Xcode(gcc(clang)) | 未 |

| GNOME Builder(gcc) | 未 |

| KDE(gcc) | 未 |